科幻照进现实

当阿西莫夫在小说《转圈圈》(Runaround)中向世界介绍他著名的机器人三定律时,他可能没有完全预见到,八十年后的世界会多么接近他的科幻梦想。如今,我们生活在一个由人工智能(Artificial Intelligence, AI)渗透的世界里。AI系统在许多方面已超越阿西莫夫的想象——在家里,私人AI助手不仅可以帮你安排日程,还能根据你的心情推荐娱乐节目。工作中,各种AI分析工具帮你洞察复杂数据,提供行业和科学洞见。甚至在艺术领域,AI也在帮助千千万万的艺术家创作新颖的作品,挑战我们对创造力的传统认识。

这还只是冰山一角。

AI气象模型[1]已为我们预测天气,它比代表人类千万年经验的传统数值预报方法还要准确,速度也要快上一万倍;AI教学平台正在根据学生的学习习惯和进度提供个性化指导[2],使教育更加有效和包容;AI医疗模型也正帮助医生更准确快速地诊断罕见病[3]、癌症[4]、神经退行性疾病[5],在某些情况下,它们的表现甚至超过了人类专家。

然而,这些进步引发了一个问题:

这些先进的AI系统是否代表着人类对通用人工智能(AGI),或“(超)人类层级的智能”的终极设想?

自1956年达特茅斯会议提出“人工智能”这一概念以来,实现人类水平的智能一直是AI领域的圣杯。今年上半年,终于有主流研究者提出[6],AI模型——或者更确切地说,大语言模型——已经表现出“通用人工智能的火花”(sparks of AGI)。这似乎表明,AGI已经从哲学猜想变成了将来的未来。然而,关于AGI的观点众说纷纭,大语言模型也常有愚蠢行为出现,这些都引发了对AGI的质疑。在此背景下,我们需要明确几个关键问题:我们的AGI目标到底是什么?我们离实现真正的AGI还有多远?我们如何预测AGI的社会影响并评估其潜在风险?

想回答这些问题,首先要在那些带有迷惑性的科幻作品之外,准确地、可操作地定义AGI。

尝试定义AGI

尝试定义通用人工智能的概念,最早可追溯到上世纪五十年代著名的“图灵测试” [7]。在这一测试中,人类需要使用文本,与某未知对象进行交流,并据此判断对面是机器还是人类。图灵的洞见在于,机器是否能“思考”不取决于其思考过程,而在于其表现的能力。但是,因为人类太容易被糊弄,这一测试通常并不能很好地反映智能的程度。

此后,约翰·瑟尔(John Searle)在他著名的“中文房间”[8]思想实验中,则将AGI视作一种有“意识”的强AI系统。虽然将AI与“意识”相连听起来很诱人,但这更多是哲学上的讨论,而非可验证的科学,因为“意识”本身更是一个难以被科学定义的概念。

而在马克·古布鲁德(Mark Gubrud)1997年首次提出AGI这一概念时,他将AGI类比于人脑——一种能在复杂性和速度上超越人脑,能获取和内化知识,被用于需要运用人类智慧来解决问题的用途之上。但问题在于,现代的AI系统,比如基于Transformer模型,与人类的大脑结构和学习模式的联系其实并不紧密。

更近地,本世纪初,当DeepMind联合创始人谢恩·莱格(Shane Legg)将AGI的概念向计算机科学家们普及时[9],他将AGI定义为在认知任务上能取得类人表现的机器智能。但这一定义并未明确所指的任务类型和“类人”标准。

除此之外,近期还有从学习任务或元认知能力(不充分),经济价值(不必要不充分),灵活性(不充分)等方面对AGI的定义尝试,但它们都有各自的问题。在今年,还有一些极具影响力的科学家提出[10],当前最佳(SOTA)的大语言模型已经是AGI,因为它们在许多任务上都能取得一定的表现,足够通用;但是,在通用之外,真正的AGI还必须拥有足够可靠的性能。

事实上,所有这些尝试都在试图定义一个AI发展的“临界”或“终极”状态。但是,我们通向AGI的巅峰之旅,恐非一点之极,而似层峦叠嶂、地形错综的高原。

▷图 1:原始论文,参考文献12。

最近,谢恩·莱格带领DeepMind团队总结历史上的定义,并在此基础上提出了他们对AGI的定义框架[12]。

从理论到实践:定义AGI的六大原则

从这些过去定义AGI的尝试中,研究人员发现了一些共同特征,并从中提取出定义AGI所必须满足的六大原则:

1.注重能力,而非过程:AGI的定义应关注于其能完成的任务,而非完成这些任务的具体方式。这意味着,实现AGI并不意味着系统必须以类似人类的方式思考或理解。

2.注重通用性与性能:AGI不仅要能够执行广泛的任务(广度、通用性),还要在这些任务上都能达到一定水平(深度、性能)。

3.注重认知与元认知任务:AGI必须在有能力处理认知任务(如解决问题、创造性思考)的同时,具有元认知能力(如学习新技能,或知道何时向人类请求帮助)。

4.专注于潜力而不是实际应用:评估AGI时,应关注的是其潜在能力,而非它目前的实际应用情况(取决于在真实世界中的部署)。

5.重视实际适用性:AGI应能解决现实世界中的实际问题,它的价值在于能够应对现实生活中复杂和多样化的挑战。

6.关注实现AGI的路径,而非单一终点:正如通过一套自动化驾驶的标准体系会更有助于针对自动驾驶车辆相关的政策制定和进程推进一样,定义AGI在不同“水平”上的衡量标准是很有益的。AGI的发展就像是一次长途跋涉,终极目标可能不是一个固定点,而是一个不断演进的过程。

理解AGI:定义层级

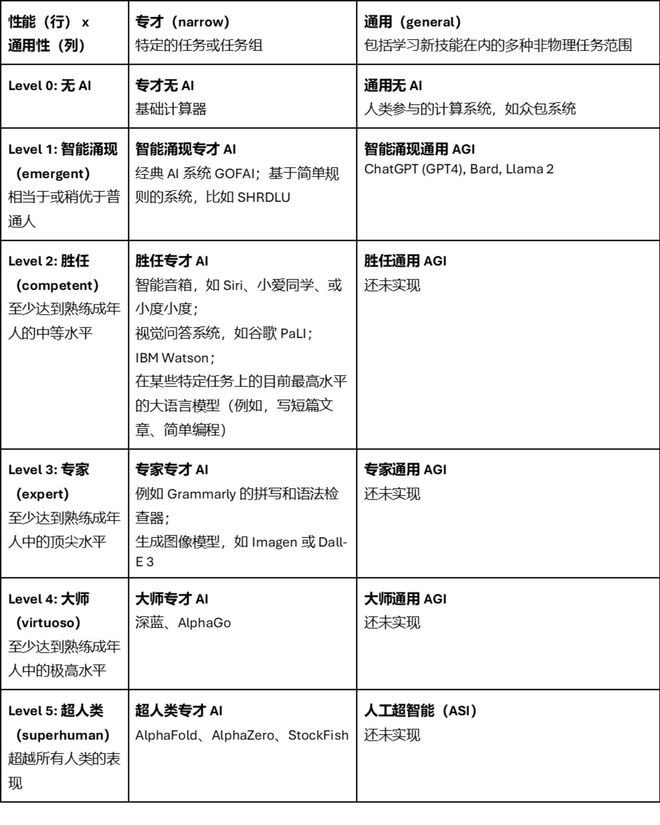

由此,研究人员将“性能”和“通用性”作为评估AI系统AGI程度的两个核心维度。其中,“性能”测量AI系统能力的“深度”,即在给定任务中与人类表现相比,AI系统达到的水平如何。“通用性”测量AI系统能力的“广度”,即AI系统能解决的任务范围。如果把没有AI时的计算系统当作AI发展的起点(比如最基础的计算器),把超过所有人类表现的AI系统当作AI的终极形态(比如国际象棋界孤独求败的AlphaZero[11]),那么便可以把AI的性能发展分为六个阶段:无AI、智能涌现、胜任、专家、大师、超人类。同时,研究人员把AI系统分为专一于特定任务的“专才”系统和胜任各类任务的“通用”系统。这样就可以把现有的AI系统作如下分类:

▷图 2:基于能力的深度(性能)和广度(普遍性)对AGI道路系统进行分类的分级矩阵方法。每个单元中的示例系统是基于文献中的当前描述或与部署的系统交互的经验的近似值。图源:参考文献12,由追问译。

使用这一框架测试通用人工智能

AGI测试是评估AI全面能力的关键步骤。上述六大原则为AGI的理解和测量提供了一个全面的框架。其中,普适性和性能原则引导研究者构建了一个分层的本体论框架,以深入讨论AI的广度和深度。

在AGI测试中,性能的维度是比较直观的:我们可以通过比较AI系统与人类在相同任务上的表现来评价它。这就好比在一场围棋比赛中,我们不仅会看棋手赢了多少盘,还要看他们击败了哪些级别的对手。

通用性的维度则更具挑战性。它要求我们回答一个关键问题:一个AI系统需要掌握哪些任务,才能被认为具有足够的广泛性?例如,一个能够进行数学推理、理解自然语言、甚至创作音乐的AI,显然展现了更广泛的能力范围,但这足够通用吗?这就像在技能的茫茫宇宙中找到最具代表性的星体,既要足够广泛又要足够重要。对此,研究人员认为,还需要更多的研究。

值得一提的是,在评估AGI的性能时,所使用的测试应当尽可能地贴近真实世界的应用场景。例如,评估自动驾驶汽车时,比较其与不使用任何现代AI辅助工具的人类驾驶员并不够有说服力。反而,应当将其与那些已经采用某些驾驶辅助技术的人类驾驶员进行比较,这样的比较才更有意义。

此外,AGI的基准测试可能会包含一些开放性和互动性的任务,这些任务可能需要定性评估(换句话说就是人类的主观评价)。这就像是在一场艺术比赛中,裁判不仅要考虑作品的技术程度,还要评价创意和表现力。例如,我们可能要求AI系统解读文学作品,或者创作一首诗,这些任务不仅考验AI的技术能力,还考验其创新性和对人类情感的理解。

最后,构建一个AGI的基准测试是一个需要不断迭代和改进的过程。这个基准本身也必须不断更新,以适应AGI可能完成的各种任务,毕竟我们永远也无法穷举所有AGI应完成的任务。这不仅仅是为了测量AGI的当前能力,更是为了激发它向更高的智能进化。这个过程既是技术的挑战,也是我们对智能理解深度的体现,更重要的是,它将引导技术发展的未来走向。

其他研究方向

除了构建AGI的基准测试外,要想更好的向AGI迈进,其他几个研究方向也尤为关键。

对齐

对齐(alignment)的目标,是确保AI系统的行为与人类的利益和价值观保持一致。这是避免AI系统产生不可预料后果和潜在危害的关键。在今年的NeurIPS和2024年的ICLR投稿中,就有大量的论文和研究集中这一领域,突出了其重要性。它们不仅关注理论和技术的进步,还涉及相应的治理手段,以确保AI在复杂和动态的环境中依然能够遵循人类的伦理和价值观。随着AI系统与社会的逐步融合,对齐研究的价值将日益凸显。

机械解释性

机械解释性(mechanistic interpretability)相关的研究旨在揭示AI系统如何做出决策,以及这些决策背后的机制。通过增强我们对AI系统内部运作的理解,可以更好地监控和指导这些系统的行为,确保它们的行为符合人类的期望和标准。

跨学科合作

跨学科合作在AGI研究中也起着至关重要的作用。从计算机科学到哲学、心理学、神经科学、法学、社会学、乃至政治学,各个学科的专家都需要共同努力,以确保AI系统的设计和应用不仅在技术上先进,而且在伦理和社会层面上不掉队。这种合作将有助于我们更全面地理解AGI的潜在影响,并为其带来的挑战提供创新的解决方案。

风险的多面性:从存在性到极端风险

当我们探讨AGI时,各种风险概念经常被提及,从“x-risk”(existential risk,即存在性风险)到各类极端风险。所谓存在性风险,是指对人类生存造成威胁的风险,而极端风险则涵盖了一系列可能对社会造成严重影响的危险。这些风险的多面性不仅让我们对未来充满好奇,也提醒我们要谨慎前行,毕竟在每个转角都可能隐藏着新的挑战和机遇。

AGI等级与风险评估

通过定义AGI层级框架,我们能够更清晰地看到不同等级的AGI所带来的风险,而不是将其视为一个单一的事件进行评估。在这套框架下,政策制定者能够识别并优先处理当下发展阶段带来的风险。例如,专家级AGI可能会导致人们的工作岗位被机器智能取代,使得经济领域出现动荡,但同时也可能减少在较低级别AGI中出现的一些问题,如任务执行不当的风险。这就像在攀登科技高峰时,需要不断地平衡和调整,以确保人类不会在追求高度的同时丧失了安全。

但是,必须承认,技术的迭代速度,特别是在AGI领域,可能会超越现有的法规和外交政策的步伐。我们已然驾驶着一辆超高速的列车,但现有的道路规则可能还停留在马车时代。这将带来更为复杂的影响。比如,首个达到ASI(人工超智能)的国家可能会获得巨大的地缘政治和军事优势,而这可能会引发一系列风险和挑战。

正因如此,研究人员认为,AGI的基准测试不仅应是对AI能力的测量,也更应是对其潜在风险的评估。这其中包括了如何处理AGI可能具备的危险能力,如欺骗和暗示性说服。我们在培养一个全能的个体时,不仅要教给它知识和技能,还要教会它如何负责任和道德地使用这些能力。例如,Anthropic推出的负责任扩展政策[12],通过为不同级别AI系统设定不同的风险等级和防范措施,展示了一种平衡创新与安全的方法。

自主性与风险:设计的艺术

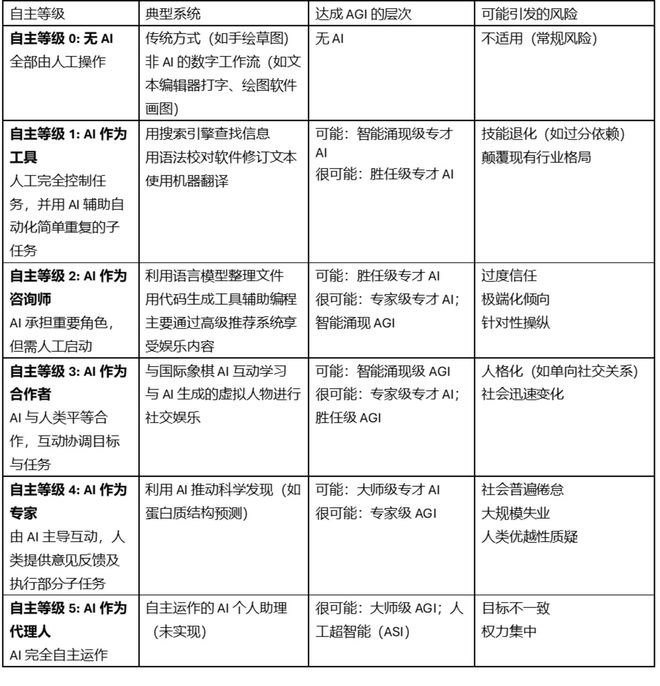

在考虑AGI的应用时,我们也需要思考它们如何与人类互动。还是回到自动驾驶汽车的例子,完全自主的车辆(Level 5)无需人类干预,而对较低自主层级(如Level 2)的车辆,人类司机仍然扮演重要的监控和控制角色。在下表中,研究人员通过六级自主性来描述人机交互的范式。在这套范式中,AI系统自主化等级与其综合能力存在着直接联系。这意味着,随着 AI 系统变得更加高级和自主,它们能够提供更多样化的交互方式,同时也可能引入不同类型的风险。

自主性的不同层级代表了人类与AI之间合作的不同方式。有时,即使技术上可实现更高级别的自主性,但出于教育、娱乐或安全的考虑,选择较低级别的自主性可能仍是更明智的选择。例如,在自动驾驶领域,即使有能力实现完全自动驾驶,我们仍宁可选择让人类司机参与,以保证安全和适应性。将AGI系统置于实际使用场景中考虑,可以帮助我们更好地理解模型进步与人工智能交互范式进步之间的关系。这种考虑方式不仅能够帮助我们预测 AI 系统的发展方向,还能指导我们在设计这些系统时,如何确保这些进步既服务于人类需求,又不牺牲安全。

▷图 3:不同自主等级达成的AGI层次,以及其可能引发的风险。图源:参考文献12,由追问译

OpenAI的观点:AI发展及其对社会的影响

今年更早些时候,OpenAI的CEO萨姆·奥特曼(Sam Altman)在他的博客文章Planning for AGI and Beyond[12]里,探讨了AGI对社会、技术和伦理的潜在影响,并强调了慎重规划和负责任的发展的必要性。

文章指出,通过增加资源丰富度、推动全球经济增长,以及助力新科学知识的发现,AGI有潜力极大地提升人类生活质量。这不仅是智力的巨大增幅,更是对人类创造力和想象力的极大扩展。然而,AGI的出现也可能带来严重的滥用风险、意外极端事件的可能以及对社会结构的剧烈动荡。因此,OpenAI提倡在发展AGI时,AGI开发者以及全社会都必须找到正确的方法来实现和利用这一技术,确保其与人类核心价值观保持一致,并公平地分享其带来的好处。

此外,OpenAI认为,从长远来看,AGI的出现仅仅是智力发展的一个节点,而人工智能的进步可能会在未来相当长一段时间内继续保持。OpenAI提出了一个安全的AGI发展愿景,即在较短时间内以较慢的速度过渡到AGI,以便社会有时间适应和调整。

尽管未来不可预知,但OpenAI表达了他们最关心的几个原则:

希望AGI能最大限度地促进人类在宇宙中的繁荣;希望AGI带来的好处、访问权和治理能够被广泛且公平地分享,并成功应对巨大风险。

为此,OpenAI倡导在短期内进行渐进式过渡、继续创造越来越符合目标的模型,并在长期进行全球范围的对话,讨论如何治理这些系统、如何公平分配它们产生的好处,以及如何公平分享访问权。这一过渡到拥超智能的世界的过程,可能是人类历史上最重要且最充满希望和恐惧的时间,没有人能保证成功。但在极高的风险和回报下,全人类需要团结起来,让AGI在未来世界以一种对人类最有益的方式绽放。

结论:稳步前行的必要性

总的来说,AGI的进步不仅代表了技术创新,更是对未来人机交互方式的重新想象。随着我们探索AGI的未知领域,稳健和有序的发展是至关重要的,它确保了人类在追求技术的同时,不会忽视潜在风险。通过理解 AGI 系统的不同发展水平和相应的自主性水平,我们能够不断地评估和调整步伐,更好地准备应对未来的挑战,同时确保这些技术的发展能够以安全、负责任的方式造福人类。

参考文献:

[1] Bi, K. et al. (2023) Accurate medium-range global weather forecasting with 3D Neural Networks, Nature News. Available at: https://www.nature.com/articles/s41586-023-06185-3.

[2] Mathgpt大模型发布:落地学而思AI学习机 (2023) 机器之心. Available at: https://www.jiqizhixin.com/articles/2023-11-06-16.

[3] Alsentzer, E. et al. (2022) Deep learning for diagnosing patients with rare genetic diseases, medRxiv. Available at: https://www.medrxiv.org/content/10.1101/2022.12.07.22283238v1.

[4] Song, A.H. et al. (2023) Artificial Intelligence for digital and Computational Pathology, Nature News. Available at: https://www.nature.com/articles/s44222-023-00096-8 .

[5] Yang, Y. et al. (2022) Artificial Intelligence-enabled detection and assessment of parkinson’s disease using nocturnal breathing signals, Nature News. Available at: https://www.nature.com/articles/s41591-022-01932-x .

[6] Bubeck, S. et al. (2023) Sparks of artificial general intelligence: Early experiments with GPT-4, arXiv.org. Available at: https://arxiv.org/abs/2303.12712 .

[7] Oppy, G. and Dowe, D. (2021) The turing test, Stanford Encyclopedia of Philosophy. Available at: https://plato.stanford.edu/entries/turing-test/.

[8] Cole, D. (2020) The Chinese Room Argument, Stanford Encyclopedia of Philosophy. Available at: https://plato.stanford.edu/entries/chinese-room/.

[9] Legg, S. (2022) In 2001 I suggested the term to @bengoertzel for the book he was writing. the term Agi caught on after he published it. Some years later we found out that Mark Gubrud used the term back in 1997 in a nanotechnology and security paper., Twitter. Available at: https://twitter.com/ShaneLegg/status/1529483168134451201.

[10] Arcas, B.A. y (2023) Artificial General Intelligence is already here, NOEMA. Available at: https://www.noemamag.com/artificial-general-intelligence-is-already-here/.

[11] Silver, D., Kasparov, G. and Habu, Y. (2018) Alphazero: Shedding new light on chess, Shogi, and go, Google DeepMind. Available at: https://deepmind.google/discover/blog/alphazero-shedding-new-light-on-chess-shogi-and-go/.

[12] Morris, Meredith Ringel, et al. "Levels of AGI: Operationalizing Progress on the Path to AGI." arXiv preprint arXiv:2311.02462 (2023).

[13] Sam, A. (2023) Planning for AGI and beyond. Available at: https://openai.com/blog/planning-for-agi-and-beyond.